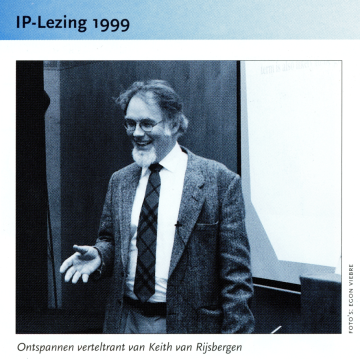

Bij de allereerste IP-lezing – de verre voorloper van de huidige VOGIN-IP-lezingen – in 1999 was Keith van Rijsbergen de keynote spreker. Van oorsprong Nederlander (hij heette Kees), was hij al jarenlang hoogleraar in Glasgow. En een beroemdheid op het gebied van Information retrieval.  In 1999 peperde hij zijn toehoorders bij IP al in, dat het Booleaanse model voor de meeste zoektoepassingen volstrekt ongeschikt was. Nu, 25 jaar later, zijn de meeste mensen daar intussen wel van overtuigd – ook al zijn er nog altijd toepassingen waarvoor Booleaanse combinaties wel degelijk nog tot goede resultaten leiden.

In 1999 peperde hij zijn toehoorders bij IP al in, dat het Booleaanse model voor de meeste zoektoepassingen volstrekt ongeschikt was. Nu, 25 jaar later, zijn de meeste mensen daar intussen wel van overtuigd – ook al zijn er nog altijd toepassingen waarvoor Booleaanse combinaties wel degelijk nog tot goede resultaten leiden.

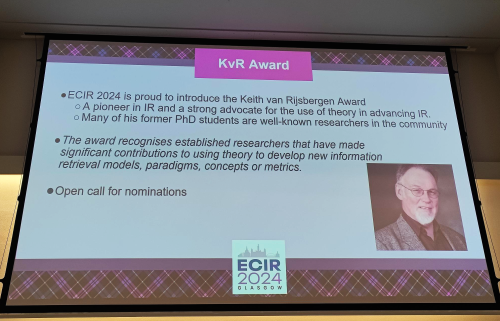

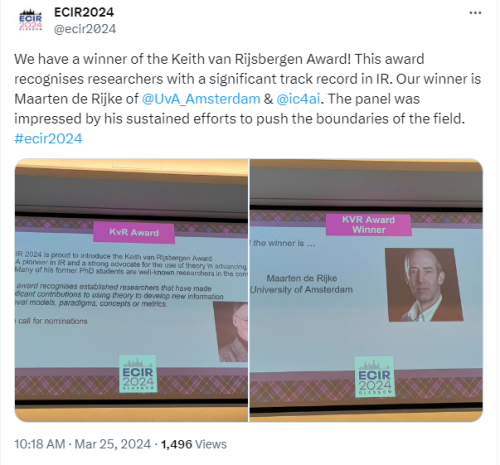

Op de European Conference on Information Retrieval (ECIR) die vorige maand in zijn thuisstad Glasgow werd gehouden, is een naar Keith van Rijsbergen genoemde prijs uitgereikt. En die ging dit keer naar een andere Nederlander, Maarten de Rijke. Ook een goede bekende, want 10 jaar geleden was Maarten onze keynote spreker op de tweede VOGIN-IP-lezing.

Op de European Conference on Information Retrieval (ECIR) die vorige maand in zijn thuisstad Glasgow werd gehouden, is een naar Keith van Rijsbergen genoemde prijs uitgereikt. En die ging dit keer naar een andere Nederlander, Maarten de Rijke. Ook een goede bekende, want 10 jaar geleden was Maarten onze keynote spreker op de tweede VOGIN-IP-lezing.

Na zijn keynote op 25 februari 2014 ontvangt Maarten de Rijke

van dagvoorzitter Boyd Hendriks de gebruikelijke sprekersvergoeding