Eind vorig jaar vierde Google zijn 25ste verjaardag. In het kader van de VOGIN-IP-lezing die immers “zoeken & vinden” als thema heeft, willen we daar graag nog even bij stilstaan. In IP hebben we dat destijds ook gedaan bij 15 jaar Google.

Eind vorig jaar vierde Google zijn 25ste verjaardag. In het kader van de VOGIN-IP-lezing die immers “zoeken & vinden” als thema heeft, willen we daar graag nog even bij stilstaan. In IP hebben we dat destijds ook gedaan bij 15 jaar Google.

De traditie wil dat Google, zoals veel technologiebedrijven, in een garage is ontstaan. Toch is dat niet helemaal waar, want Larry Page en Sergey Brin hadden in 1998 hun nieuwe zoekmachine ontwikkeld als onderdeel van hun studie aan Stanford University. Het allereerste URL was dan ook google.stanford.edu.

De traditie wil dat Google, zoals veel technologiebedrijven, in een garage is ontstaan. Toch is dat niet helemaal waar, want Larry Page en Sergey Brin hadden in 1998 hun nieuwe zoekmachine ontwikkeld als onderdeel van hun studie aan Stanford University. Het allereerste URL was dan ook google.stanford.edu.

Pas toen Google echt een product werd, kwam die garage in beeld. Toen hadden ze intussen al 25 miljoen pagina’s geïndexeerd. Dat was een eerste stapje op weg naar Google’s oorspronkelijke ambitie om alle kennis van deze wereld vindbaar te willen maken. Bij het 15-jarig bestaan in 2013 was die ambitie echter al aardig verwaterd geraakt; de zoekmachine was intussen alleen nog maar een succesvol hulpmiddel om advertenties te verkopen.

Pas toen Google echt een product werd, kwam die garage in beeld. Toen hadden ze intussen al 25 miljoen pagina’s geïndexeerd. Dat was een eerste stapje op weg naar Google’s oorspronkelijke ambitie om alle kennis van deze wereld vindbaar te willen maken. Bij het 15-jarig bestaan in 2013 was die ambitie echter al aardig verwaterd geraakt; de zoekmachine was intussen alleen nog maar een succesvol hulpmiddel om advertenties te verkopen.

Van de minstens vijftien zoekmachines waaraan IP in voorgaande jaren al aandacht had besteed, was op dat moment naast Google alleen Bing nog overgebleven.

Van de minstens vijftien zoekmachines waaraan IP in voorgaande jaren al aandacht had besteed, was op dat moment naast Google alleen Bing nog overgebleven.

Overigens had Google zelf pas eind 2000 de op dat moment nog aanwezige concurrentie in grootte gepasseerd. En daarna heeft het nog tot circa 2007 geduurd voordat Google de andere definitief achter zich gelaten had.

Sinds de eerste echte zoekmachine (Lycos) rond 1993 verdubbelde 15 jaar lang ongeveer ieder jaar het aantal webpagina’s in de op dat moment grootste zoekmachine.

Sinds de eerste echte zoekmachine (Lycos) rond 1993 verdubbelde 15 jaar lang ongeveer ieder jaar het aantal webpagina’s in de op dat moment grootste zoekmachine.

De race wie de grootste was, verloor trouwens al steeds meer aan betekenis. Het werd moeilijker om te definiëren wat daarvoor nog als afzonderlijke webpagina’s geteld moesten worden. Is elke tweet een webpagina? Heb je te maken met een andere pagina als automatisch een iets ander sessienummer in een URL wordt verwerkt of als één van de 20 blokjes informatie op een pagina verschilt van die in een vorige versie? Zijn gepersonaliseerde pagina’s die verschillende gebruikers op dezelfde site te zien krijgen, verschillende pagina’s? Daarnaast zijn de “items” die je op internet vindt steeds onvergelijkbaarder. Tellen miljarden tweets van 140 tekens bij het vergelijken van groottes even zwaar mee als PDF’s van 140 bladzijden? Vandaar dat de grafiek hierboven in een “pluim” uitloopt, die bij 2013 zelfs helemaal ophoudt.

Waarom zocht Google zo goed?

Belangrijk voor de snelle acceptatie van Google was de goede relevantie-ordening die het geïntroduceerd had. Die ranking berustte voor een belangrijk deel op een soort citatie-algoritme, de Pagerank. Hoe meer backlinks er waren vanaf andere pagina’s, en hoe hogere Pagerank die pagina’s zelf hadden, hoe beter. Daarbij heeft de “page” in “Pagerank” niet alleen betrekking op die “pagina’s”, maar is het ook een toespeling op de achternaam van Larry Page. De Pagerank is heel lang de basis van Google’s ranking gebleven (en voor aanbieders van websites de na te streven gouden standaard om hun vindbaarheid te garanderen). Bovendien was Google groot – en dus schijnbaar volledig – en had het zo’n eenvoudig “kaal” gebruikersinterface, vergeleken met andere zoeksystemen.

Belangrijk voor de snelle acceptatie van Google was de goede relevantie-ordening die het geïntroduceerd had. Die ranking berustte voor een belangrijk deel op een soort citatie-algoritme, de Pagerank. Hoe meer backlinks er waren vanaf andere pagina’s, en hoe hogere Pagerank die pagina’s zelf hadden, hoe beter. Daarbij heeft de “page” in “Pagerank” niet alleen betrekking op die “pagina’s”, maar is het ook een toespeling op de achternaam van Larry Page. De Pagerank is heel lang de basis van Google’s ranking gebleven (en voor aanbieders van websites de na te streven gouden standaard om hun vindbaarheid te garanderen). Bovendien was Google groot – en dus schijnbaar volledig – en had het zo’n eenvoudig “kaal” gebruikersinterface, vergeleken met andere zoeksystemen.

Daarnaast is Google in de loop der tijd steeds meer aan vraagverbetering gaan doen. Synoniemen en spellingsvarianten van gebruikte zoektermen werden automatisch ook in zoekacties meegenomen. Dit zijn voorbeelden van de semantische zoektechnieken die Google meer en meer introduceerde. Daarbij ging het meer om de betekenis van termen dan om de precieze reeks letters die als zoekvraag was ingetikt, onder het motto ‘not STRINGS but THINGS’. Bovendien speelde de ingeschatte intentie van de zoeker een steeds belangrijker rol. Zo werd pure Pagerank allengs van minder belang voor de volgorde van presenteren van de zoekresultaten en zelfs voor wat wel of niet getoond werd. Kennis over wat een gebruiker eerder gezocht en bekeken had, werd zeker zo belangrijk als de op backlinks gebaseerde Pagerank. Voor wie wilde weten welke factoren toen allemaal meespeelden. publiceerde wijlen Bill Slawski in 2018 een uitputtend overzicht van de “Google Ranking Signals”.

Belangrijk hulpmiddel bij veel van de nieuwe technieken werd de door Google opgezette Knowledge Graph, waarin semantische relaties tussen meer dan een miljard begrippen waren vastgelegd.

Op basis van zoektermen werden daaruit zogenaamde “caroussels” en “knowledge cards” met achtergrondinformatie gegenereerd, die naast of tussen de gewone zoekresultaten werden getoond. Aanvankelijk werd het aan de gebruiker overgelaten welke keuze die wilde maken uit de daarmee aangereikte begrippen om zoekacties uit te breiden of in te perken. Belangrijk hierbij was ook de toepassing van Google’s RankBrain machine learning techniek om te herkennen waar zowel zoekvragen als gevonden webpagina’s “echt” over gaan. Allengs liet Google ook steeds meer automatisch gebeuren. Al die automatische aanpassingen van zoekvragen ontlokten bij professionele zoekers soms wel de verzuchting dat Google zich niet met hun vraag moest bemoeien, want dat ze zelf het beste wisten wat ze zochten.

Op basis van zoektermen werden daaruit zogenaamde “caroussels” en “knowledge cards” met achtergrondinformatie gegenereerd, die naast of tussen de gewone zoekresultaten werden getoond. Aanvankelijk werd het aan de gebruiker overgelaten welke keuze die wilde maken uit de daarmee aangereikte begrippen om zoekacties uit te breiden of in te perken. Belangrijk hierbij was ook de toepassing van Google’s RankBrain machine learning techniek om te herkennen waar zowel zoekvragen als gevonden webpagina’s “echt” over gaan. Allengs liet Google ook steeds meer automatisch gebeuren. Al die automatische aanpassingen van zoekvragen ontlokten bij professionele zoekers soms wel de verzuchting dat Google zich niet met hun vraag moest bemoeien, want dat ze zelf het beste wisten wat ze zochten.

Veel verdergaande mogelijkheden dan alleen maar semantische functionaliteit werden mogelijk met de recente opkomst van generatieve kunstmatige intelligentie op basis van zogenaamde “Large Language Models”. Google heeft bij die ontwikkeling aangehaakt door, als concurrent voor het alom bewierookte ChatGPT, ook een eigen chatbot “Bard” te ontwikkelen.  Als reactie op vragen/opdrachten geeft die niet een lijstje met “blauwe links”, maar – veel meer dan bij de eerdere semantische zoeksystemen – in keurige volzinnen geformuleerde en beargumenteerde antwoorden en eventuele aanpassingen op zoekvragen.

Als reactie op vragen/opdrachten geeft die niet een lijstje met “blauwe links”, maar – veel meer dan bij de eerdere semantische zoeksystemen – in keurige volzinnen geformuleerde en beargumenteerde antwoorden en eventuele aanpassingen op zoekvragen.  Recent heeft Google deze chatbot de nieuwe naam “Gemini” gegeven.

Recent heeft Google deze chatbot de nieuwe naam “Gemini” gegeven.

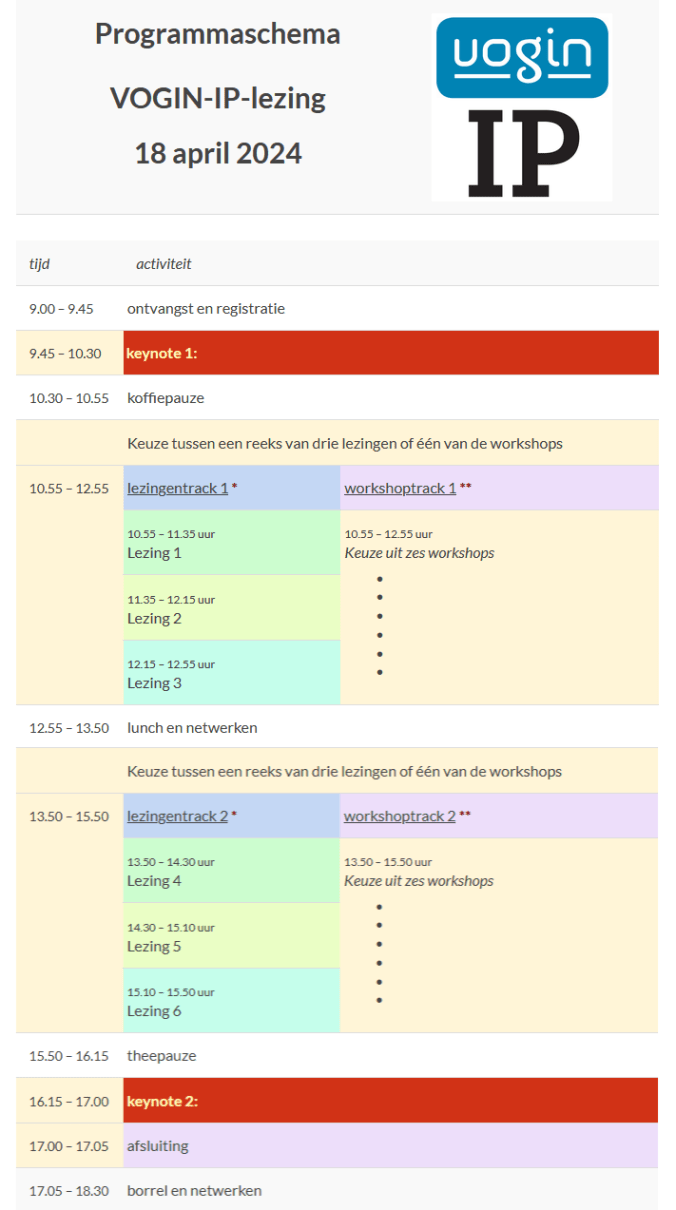

In de workshop “Prompt Engineering” kunnen deelnemers op 18 april met dit systeem kennis maken en leren hoe je “prompts” (opdrachten) in een iteratief proces zodanig kunt (her)formuleren dat je betere antwoorden krijgt.

Door de hier geschetste ontwikkelingen heeft Google van een “zoekmachine” tot een “antwoordmachine” kunnen evolueren.

Nog wat extra plussen en minnen

Google biedt ook nog een heleboel tools en diensten, waarvan een deel niet rechtstreeks met zoeken en vinden te maken heeft. In de loop van de jaren zijn dat er steeds meer geworden, maar intussen zijn er ook al weer een heleboel verdwenen (waar ik straks nog op terug kom).

Een voorbeeld van een niet-zoek dienst is het “Structured data testing tool” waarmee embedded metadata in webpagina’s, zoals Schema.org markup, geanalyseerd kan worden. En een alom veel bekender voorbeeld is natuurlijk Gmail, dat Microsoft’s Hotmail al snel als favoriet gratis mailprogramma verdrongen had. Voorbeelden die wel direct met zoeken te maken hebben, zijn enerzijds functies die we verder vooral van betaalde zoeksystemen kennen, zoals het gebruik van zoekvelden (filetype:, site:, inurl:, intitle: e.d.). Anderzijds zijn er allerlei aparte zoeksystemen voor specifieke soorten materiaal, zoals wetenschappelijke publicaties (Google Scholar, dat een concurrent is voor betaalde bibliografische zoeksystemen – en waarvan het interface nogal afwijkt van Google’s andere zoekdiensten), nieuws (uit vele honderden kranten en tijdschriften wereldwijd), boeken (Google Books, met full-text doorzoekbare inhoud van gescande boeken), octrooien (Google patents), video’s (YouTube, dat elders ontwikkeld was, maar door Google is aangekocht), afbeeldingen (Google Image, dat zijn plaatjes uit webpagina’s haalt) en foto’s (Google Photos, wat vooral bedoeld is om eigen foto’s te uploaden). Al die diensten bieden hun eigen specifieke filtermogelijkheden.

Een voorbeeld van een niet-zoek dienst is het “Structured data testing tool” waarmee embedded metadata in webpagina’s, zoals Schema.org markup, geanalyseerd kan worden. En een alom veel bekender voorbeeld is natuurlijk Gmail, dat Microsoft’s Hotmail al snel als favoriet gratis mailprogramma verdrongen had. Voorbeelden die wel direct met zoeken te maken hebben, zijn enerzijds functies die we verder vooral van betaalde zoeksystemen kennen, zoals het gebruik van zoekvelden (filetype:, site:, inurl:, intitle: e.d.). Anderzijds zijn er allerlei aparte zoeksystemen voor specifieke soorten materiaal, zoals wetenschappelijke publicaties (Google Scholar, dat een concurrent is voor betaalde bibliografische zoeksystemen – en waarvan het interface nogal afwijkt van Google’s andere zoekdiensten), nieuws (uit vele honderden kranten en tijdschriften wereldwijd), boeken (Google Books, met full-text doorzoekbare inhoud van gescande boeken), octrooien (Google patents), video’s (YouTube, dat elders ontwikkeld was, maar door Google is aangekocht), afbeeldingen (Google Image, dat zijn plaatjes uit webpagina’s haalt) en foto’s (Google Photos, wat vooral bedoeld is om eigen foto’s te uploaden). Al die diensten bieden hun eigen specifieke filtermogelijkheden.

Helemaal een beetje anders zijn Google Groups (waar intussen heel wat meer inzit dan alleen de klassieke nieuwsgroepdiscussies), Google Maps (dat de hele wereld in vaak hoge resolutie in kaart gebracht heeft en dat via Google streetview gecombineerd wordt met regelmatig ge-updatete foto’s vanaf “de straat”), Alerts (dat attendering op nieuw materiaal uit de meeste eerder genoemde zoeksystemen biedt), en Activity (dat de geschiedenis van je zoekactiviteiten in bijna alle Google-diensten bijhoudt, en dat de daarbij gevonden resultaten laat zien). Voor nog veel meer voorbeelden verwijs ik naar de keuzebalk die in de meeste Google-producten is op te vragen en die hier rechts naast deze tekst is afgebeeld.

En dan nog een paar van de beloofde minnen.

Ondanks de bovengenoemde extraatjes, ontbreekt toch nog veel zoekfunctionaliteit waar we in betaalde systemen wel aan gewend zijn. Zo kun je niet zoeken op metadata, kun je niet trunceren en kun je niet achteraf resultaatsets combineren. Zoeken op backlinks werkt niet meer. Zoekresultaten zijn niet reproduceerbaar en aantallen gevonden resultaten zijn niet betrouwbaar (en worden nu al helemaal niet meer getoond).

Bijzonder hinderlijk is verder nog het frequent verdwijnen van functies en diensten, zelfs als die vrij veel gebruikt werden. In de volgende paragraaf ga ik daar nog wat nader op in.

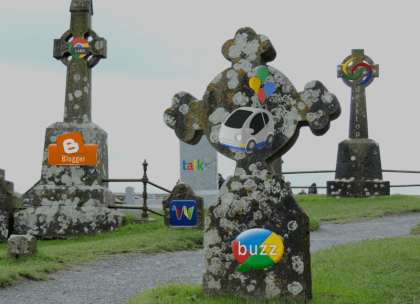

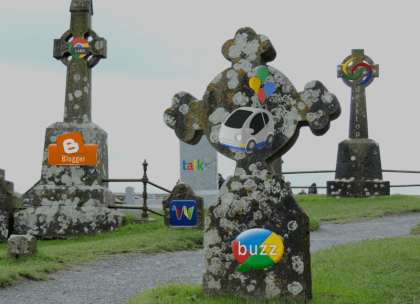

Een kerkhof van verdwenen Google-diensten

Google is altijd goed geweest in het bedenken van nieuwe functionaliteit en diensten. Alleen zijn ze vaak wat minder goed om daar voldoende publiciteit voor te maken, zodat veel ervan niet zo veel wordt gebruikt. En dat is dan weer een goede reden om een functie of dienst na een tijdje – al dan niet geruisloos – te laten verdwijnen. Zo is de afgelopen jaren een omvangrijk kerkhof met verdwenen functies, diensten en producten ontstaan. In verborgen hoekjes liggen oook nog allerlei producten die langzaam waren weggekwijnd en waarvan bijna niemand zich het bestaan meer herinnert. Maar er zijn ook volop functies en producten die door velen worden betreurd, maar die door Google meedogenloos zijn omgebracht. Een ware “graveyard of broken dreams”.

Hier een rijtje van verdwenen functies en diensten die ik zelf, soms intensief, soms incidenteel, en soms zelfs helemaal nooit gebruikt heb:

+-operator for Exact search, ~-operator for Synonym search, Translated search, Desktop search, Recipe search, Google Wave, Google Buzz, Google Reader, iGoogle, Google Directory, Google Gears, Google Notebook, Google Answers, Google Tables, Google Health, Google Toolbar, Google Pack, Google Aardvark, Google Talk, Google Labs, Google Sets, Code search, Blog search, Blogger, Sidewiki, Searchwiki, Wonderwheel, Timeline, Sites met afbeeldingen, Related Links, Knol, Image Swirl, de Google Auto, Google Glass, info-commando, (heel recent) Google Cache,…. En dan heb ik er vast nog een stel vergeten. Knap indrukwekkend. En dan somde Phil Bradley er enkele jaren geleden in zijn weblog nog tientallen meer op.

+-operator for Exact search, ~-operator for Synonym search, Translated search, Desktop search, Recipe search, Google Wave, Google Buzz, Google Reader, iGoogle, Google Directory, Google Gears, Google Notebook, Google Answers, Google Tables, Google Health, Google Toolbar, Google Pack, Google Aardvark, Google Talk, Google Labs, Google Sets, Code search, Blog search, Blogger, Sidewiki, Searchwiki, Wonderwheel, Timeline, Sites met afbeeldingen, Related Links, Knol, Image Swirl, de Google Auto, Google Glass, info-commando, (heel recent) Google Cache,…. En dan heb ik er vast nog een stel vergeten. Knap indrukwekkend. En dan somde Phil Bradley er enkele jaren geleden in zijn weblog nog tientallen meer op.

Verdwijnende zoekgoeroes

Functies en diensten zijn niet het enige dat bij Google verdwijnt. In het verleden waren er nogal wat zoekgoeroes die Google kritisch volgden, op Twitter en in hun eigen weblogs. Daar waarschuwden ze ons voor rare fouten en pitfalls die ze waren tegengekomen bij de diverse Google diensten. Maar de meeste van die goeroes doen er intussen het zwijgen toe. Gwen Harris (@websearchlady) is met pensioen en de immer kritische Phil Bradley beperkt zich tot didactische podcasts, nu ook hij met pensioen is. Greg Notess en Marydee Ojala schrijven hooguit nog wat in betaalde bladen. Henk van Ess richt zijn aandacht nu vooral op het gebruik van systemen voor generatieve AI. Van Danny Sullivan komen niet heel veel kritische geluiden meer, sinds hij, na zijn afscheid bij SearchEngineLand, bij Google zelf in dienst gekomen was. Nu pakt dat laatste soms wel goed uit, omdat zoekgebruikers via hem een laagdrempelige ingang bij Google hebben, waarlangs een overleden functie een enkele keer toch nog gereanimeerd kan worden.

Als we zien hoe Google, zelfs als we ons alleen tot zoekfuncties beperken, in 25 jaar veranderd is, dan lijkt een voorspelling hoe Google er over nog eens 25 jaar zal uitzien een kansloze uitdaging.

Eric Sieverts

Een aantal fragmenten uit deze tekst is eerder gepubliceerd in bijdragen in IP en incidenteel in andere media.

OpenAI, de maker van de ChatGPT software zou

OpenAI, de maker van de ChatGPT software zou

De workshop “

De workshop “ De workshop “

De workshop “ De workshop “

De workshop “

Eind vorig jaar vierde Google zijn 25ste verjaardag. In het kader van de VOGIN-IP-lezing die immers “zoeken & vinden” als thema heeft, willen we daar graag nog even bij stilstaan. In IP hebben we dat destijds ook gedaan bij

Eind vorig jaar vierde Google zijn 25ste verjaardag. In het kader van de VOGIN-IP-lezing die immers “zoeken & vinden” als thema heeft, willen we daar graag nog even bij stilstaan. In IP hebben we dat destijds ook gedaan bij

Pas toen Google echt een product werd, kwam die garage in beeld. Toen hadden ze intussen al 25 miljoen pagina’s geïndexeerd. Dat was een eerste stapje op weg naar Google’s oorspronkelijke ambitie om alle kennis van deze wereld vindbaar te willen maken. Bij het 15-jarig bestaan in 2013 was die ambitie echter al aardig verwaterd geraakt; de zoekmachine was intussen alleen nog maar een succesvol hulpmiddel om advertenties te verkopen.

Pas toen Google echt een product werd, kwam die garage in beeld. Toen hadden ze intussen al 25 miljoen pagina’s geïndexeerd. Dat was een eerste stapje op weg naar Google’s oorspronkelijke ambitie om alle kennis van deze wereld vindbaar te willen maken. Bij het 15-jarig bestaan in 2013 was die ambitie echter al aardig verwaterd geraakt; de zoekmachine was intussen alleen nog maar een succesvol hulpmiddel om advertenties te verkopen. Van de minstens vijftien zoekmachines waaraan IP in voorgaande jaren al aandacht had besteed, was op dat moment naast Google alleen Bing nog overgebleven.

Van de minstens vijftien zoekmachines waaraan IP in voorgaande jaren al aandacht had besteed, was op dat moment naast Google alleen Bing nog overgebleven.

Op basis van zoektermen werden daaruit zogenaamde “caroussels” en “knowledge cards” met achtergrondinformatie gegenereerd, die naast of tussen de gewone zoekresultaten werden getoond. Aanvankelijk werd het aan de gebruiker overgelaten welke keuze die wilde maken uit de daarmee aangereikte begrippen om zoekacties uit te breiden of in te perken. Belangrijk hierbij was ook de toepassing van Google’s RankBrain machine learning techniek om te herkennen waar zowel zoekvragen als gevonden webpagina’s “echt” over gaan. Allengs liet Google ook steeds meer automatisch gebeuren. Al die automatische aanpassingen van zoekvragen ontlokten bij professionele zoekers soms wel de verzuchting dat Google zich niet met hun vraag moest bemoeien, want dat ze zelf het beste wisten wat ze zochten.

Op basis van zoektermen werden daaruit zogenaamde “caroussels” en “knowledge cards” met achtergrondinformatie gegenereerd, die naast of tussen de gewone zoekresultaten werden getoond. Aanvankelijk werd het aan de gebruiker overgelaten welke keuze die wilde maken uit de daarmee aangereikte begrippen om zoekacties uit te breiden of in te perken. Belangrijk hierbij was ook de toepassing van Google’s RankBrain machine learning techniek om te herkennen waar zowel zoekvragen als gevonden webpagina’s “echt” over gaan. Allengs liet Google ook steeds meer automatisch gebeuren. Al die automatische aanpassingen van zoekvragen ontlokten bij professionele zoekers soms wel de verzuchting dat Google zich niet met hun vraag moest bemoeien, want dat ze zelf het beste wisten wat ze zochten. Als reactie op vragen/opdrachten geeft die niet een lijstje met “blauwe links”, maar – veel meer dan bij de eerdere semantische zoeksystemen – in keurige volzinnen geformuleerde en beargumenteerde antwoorden en eventuele aanpassingen op zoekvragen.

Als reactie op vragen/opdrachten geeft die niet een lijstje met “blauwe links”, maar – veel meer dan bij de eerdere semantische zoeksystemen – in keurige volzinnen geformuleerde en beargumenteerde antwoorden en eventuele aanpassingen op zoekvragen.  Recent heeft Google deze chatbot de nieuwe naam “Gemini” gegeven.

Recent heeft Google deze chatbot de nieuwe naam “Gemini” gegeven.

Een voorbeeld van een niet-zoek dienst is het “Structured data testing tool” waarmee embedded metadata in webpagina’s, zoals Schema.org markup, geanalyseerd kan worden. En een alom veel bekender voorbeeld is natuurlijk Gmail, dat Microsoft’s Hotmail al snel als favoriet gratis mailprogramma verdrongen had. Voorbeelden die wel direct met zoeken te maken hebben, zijn enerzijds functies die we verder vooral van betaalde zoeksystemen kennen, zoals het gebruik van zoekvelden (filetype:, site:, inurl:, intitle: e.d.). Anderzijds zijn er allerlei aparte zoeksystemen voor specifieke soorten materiaal, zoals wetenschappelijke publicaties (Google Scholar, dat een concurrent is voor betaalde bibliografische zoeksystemen – en waarvan het interface nogal afwijkt van Google’s andere zoekdiensten), nieuws (uit vele honderden kranten en tijdschriften wereldwijd), boeken (Google Books, met full-text doorzoekbare inhoud van gescande boeken), octrooien (Google patents), video’s (YouTube, dat elders ontwikkeld was, maar door Google is aangekocht), afbeeldingen (Google Image, dat zijn plaatjes uit webpagina’s haalt) en foto’s (Google Photos, wat vooral bedoeld is om eigen foto’s te uploaden). Al die diensten bieden hun eigen specifieke filtermogelijkheden.

Een voorbeeld van een niet-zoek dienst is het “Structured data testing tool” waarmee embedded metadata in webpagina’s, zoals Schema.org markup, geanalyseerd kan worden. En een alom veel bekender voorbeeld is natuurlijk Gmail, dat Microsoft’s Hotmail al snel als favoriet gratis mailprogramma verdrongen had. Voorbeelden die wel direct met zoeken te maken hebben, zijn enerzijds functies die we verder vooral van betaalde zoeksystemen kennen, zoals het gebruik van zoekvelden (filetype:, site:, inurl:, intitle: e.d.). Anderzijds zijn er allerlei aparte zoeksystemen voor specifieke soorten materiaal, zoals wetenschappelijke publicaties (Google Scholar, dat een concurrent is voor betaalde bibliografische zoeksystemen – en waarvan het interface nogal afwijkt van Google’s andere zoekdiensten), nieuws (uit vele honderden kranten en tijdschriften wereldwijd), boeken (Google Books, met full-text doorzoekbare inhoud van gescande boeken), octrooien (Google patents), video’s (YouTube, dat elders ontwikkeld was, maar door Google is aangekocht), afbeeldingen (Google Image, dat zijn plaatjes uit webpagina’s haalt) en foto’s (Google Photos, wat vooral bedoeld is om eigen foto’s te uploaden). Al die diensten bieden hun eigen specifieke filtermogelijkheden. +-operator for Exact search, ~-operator for Synonym search, Translated search, Desktop search, Recipe search, Google Wave, Google Buzz, Google Reader, iGoogle, Google Directory, Google Gears, Google Notebook, Google Answers, Google Tables, Google Health, Google Toolbar, Google Pack, Google Aardvark, Google Talk, Google Labs, Google Sets, Code search, Blog search, Blogger, Sidewiki, Searchwiki, Wonderwheel, Timeline, Sites met afbeeldingen, Related Links, Knol, Image Swirl, de Google Auto, Google Glass, info-commando, (heel recent) Google Cache,…. En dan heb ik er vast nog een stel vergeten. Knap indrukwekkend. En dan somde Phil Bradley er enkele jaren geleden

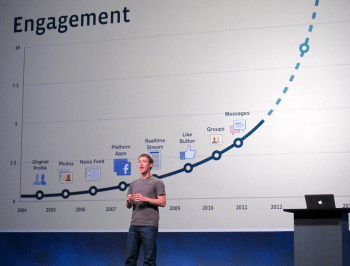

+-operator for Exact search, ~-operator for Synonym search, Translated search, Desktop search, Recipe search, Google Wave, Google Buzz, Google Reader, iGoogle, Google Directory, Google Gears, Google Notebook, Google Answers, Google Tables, Google Health, Google Toolbar, Google Pack, Google Aardvark, Google Talk, Google Labs, Google Sets, Code search, Blog search, Blogger, Sidewiki, Searchwiki, Wonderwheel, Timeline, Sites met afbeeldingen, Related Links, Knol, Image Swirl, de Google Auto, Google Glass, info-commando, (heel recent) Google Cache,…. En dan heb ik er vast nog een stel vergeten. Knap indrukwekkend. En dan somde Phil Bradley er enkele jaren geleden  Het 20-jarig jubileum van Facebook markeert een belangrijke mijlpaal in de evolutie van sociale media. Oorspronkelijk in 2004 gelanceerd als “smoelenboek” voor Harvard-studenten, werd Facebook al snel een dominante kracht in het verbinden van mensen over de hele wereld.

Het 20-jarig jubileum van Facebook markeert een belangrijke mijlpaal in de evolutie van sociale media. Oorspronkelijk in 2004 gelanceerd als “smoelenboek” voor Harvard-studenten, werd Facebook al snel een dominante kracht in het verbinden van mensen over de hele wereld.

Deze erosie van de oorspronkelijke magische formule van sociale media, waarin persoonlijke interacties werden vermengd met massale communicatie, heeft geleid tot groeiende zorgen over de negatieve impact van sociale media op de samenleving. De verspreiding van desinformatie en schadelijke inhoud heeft bijgedragen aan polarisatie, misinformatie en zelfs geweld in de echte wereld.

Deze erosie van de oorspronkelijke magische formule van sociale media, waarin persoonlijke interacties werden vermengd met massale communicatie, heeft geleid tot groeiende zorgen over de negatieve impact van sociale media op de samenleving. De verspreiding van desinformatie en schadelijke inhoud heeft bijgedragen aan polarisatie, misinformatie en zelfs geweld in de echte wereld.

Dit is belangrijk omdat sociale mediaplatforms inmiddels integrale onderdelen van de moderne samenleving zijn geworden, die de publieke discussie beïnvloeden, politieke meningen vormen en de geestelijke gezondheid beïnvloeden. De ongecontroleerde verspreiding van schadelijke inhoud vormt een bedreiging voor de democratie en sociale cohesie, waardoor het noodzakelijk is om de onderliggende problemen van sociale mediaplatforms aan te pakken.

Dit is belangrijk omdat sociale mediaplatforms inmiddels integrale onderdelen van de moderne samenleving zijn geworden, die de publieke discussie beïnvloeden, politieke meningen vormen en de geestelijke gezondheid beïnvloeden. De ongecontroleerde verspreiding van schadelijke inhoud vormt een bedreiging voor de democratie en sociale cohesie, waardoor het noodzakelijk is om de onderliggende problemen van sociale mediaplatforms aan te pakken. Als reactie op deze uitdagingen zoeken mensen steeds vaker alternatieve platforms op waar ze verhalen kunnen uitwisselen en contact kunnen leggen met anderen zonder te worden onderworpen aan hetzelfde niveau van manipulatie en schade. Deze platforms geven prioriteit aan privacy, betekenisvolle interacties en gemeenschapsvorming boven statistieken over betrokkenheid en stijgende advertentie-inkomsten.

Als reactie op deze uitdagingen zoeken mensen steeds vaker alternatieve platforms op waar ze verhalen kunnen uitwisselen en contact kunnen leggen met anderen zonder te worden onderworpen aan hetzelfde niveau van manipulatie en schade. Deze platforms geven prioriteit aan privacy, betekenisvolle interacties en gemeenschapsvorming boven statistieken over betrokkenheid en stijgende advertentie-inkomsten.

Vandaag hebben we ook een nieuwsbrief uitgestuurd, waarin we deze datum aankondigden. Als u die gemist hebt, kunt u hem

Vandaag hebben we ook een nieuwsbrief uitgestuurd, waarin we deze datum aankondigden. Als u die gemist hebt, kunt u hem